Μερικοί από τους πρώην υπαλλήλους των Open AI, Anthropic και DeepMind της Google, προειδοποιούν πως η τεχνητή νοημοσύνη ενέχει τεράστιους κινδύνους για την ανθρωπότητα, σε μια ανοιχτή επιστολή τους. Η επιστολή καλεί τις εταιρείες να δεσμευτούν για περισσότερη διαφάνεια και να καλλιεργήσουν μια κουλτούρα κριτικής που τις καθιστά υπόλογες.

Η επιστολή, υπογεγραμμένη από 13 άτομα γράφει: «Οι εταιρείες τεχνητής νοημοσύνης διαθέτουν ουσιαστικές, μη δημόσιες πληροφορίες σχετικά με τις δυνατότητες και τους περιορισμούς των συστημάτων τους. Δεν πιστεύουμε ότι μπορούμε να βασιστούμε στον οικειοθελή διαμοιρασμό (των πληροφοριών)».

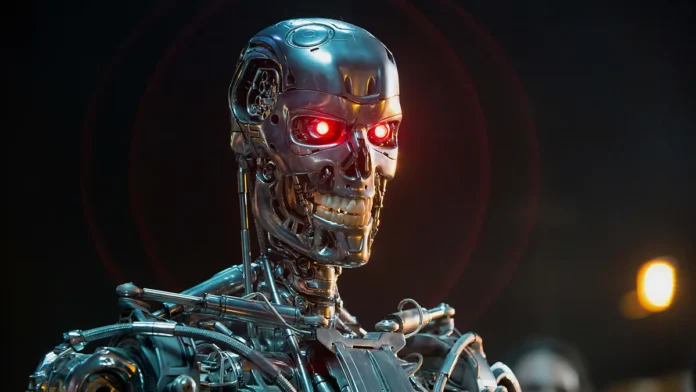

Σύμφωνα με τους υπογράφοντες, η τεχνητή νοημοσύνη μπορεί να αυξήσει την παραπληροφόρηση, να παγιώσει και αν επεκτείνει τις υπάρχουσες ανισότητες και να επιτρέψει σε οπλικά συστήματα να γίνουν αυτόνομα, κάτι που μπορεί να οδηγήσει στην ανθρώπινη εξαφάνιση. Η επιστολή αποκαλύπτει επίσης, πως εταιρίες τεχνητής νοημοσύνης και κυβερνήσεις σε όλο τον κόσμο, έχουν ήδη αναγνωρίσει αυτούς τους κινδύνους. Υποστηρίζουν όμως πως αυτοί οι κίνδυνοι μπορούν να μετριαστούν, με την κατάλληλη καθοδήγηση από τους νομοθέτες, την επιστημονική κοινότητα και το κοινό.

Συνεχίζουν, γράφοντας:

«Οι εταιρείες τεχνητής νοημοσύνης διαθέτουν ουσιαστικές, μη δημόσιες πληροφορίες σχετικά με τις δυνατότητες και τους περιορισμούς των συστημάτων τους, την επάρκεια των προστατευτικών τους μέτρων και τα επίπεδα κινδύνου διαφόρων ειδών βλάβης. Ωστόσο, επί του παρόντος έχουν δεν είναι υποχρεωμένες να μοιραστούν ορισμένες από αυτές τις πληροφορίες με τις κυβερνήσεις και καμία με την κοινωνία των πολιτών».

«Η συνήθης προστασία των πληροφοριοδοτών είναι ανεπαρκής επειδή επικεντρώνεται στην παράνομη δραστηριότητα, ενώ πολλοί από τους κινδύνους που μας απασχολούν δεν έχουν ακόμη ρυθμιστεί. Μερικοί από εμάς εύλογα φοβούνται διάφορες μορφές αντιποίνων, δεδομένου του ιστορικού τέτοιων περιπτώσεων σε ολόκληρο τον κλάδο. Δεν είμαστε οι πρώτοι που αντιμετωπίζουμε ή μιλάμε για αυτά τα θέματα».

Αυτή η επιστολή υποστηρίζεται από τον Yoshua Bengio, επιστήμονα υπολογιστών, δημοφιλή για την εργασία του στα τεχνητά νευρωνικά δίκτυα και το Deep Learning, τον Geoffrey Hinton, νονό της AI και τον Stuart Russell, Βρετανό επιστήμονα υπολογιστών.

Σε μια αποκλειστική συνομιλία με το Tech Today πέρυσι, ο Russell είχε δηλώσει ότι η ανάπτυξη μοντέλων AI είναι μια συνταγή για καταστροφή, με πιθανές συνέπειες που κυμαίνονται από τη διάδοση παραπληροφόρησης έως την ενθάρρυνση ατόμων να βλάψουν τον εαυτό τους ή τους άλλους. Είπε, «Με τη δύναμη της τεχνητής νοημοσύνης να αυξάνεται καθημερινά, είναι σημαντικό να κάνουμε ένα βήμα πίσω και να διασφαλίσουμε ότι αυτές οι ισχυρές τεχνολογίες αναπτύσσονται και υλοποιούνται με υπεύθυνο και ασφαλή τρόπο».

Όσο και αν οι εταιρίες θέλουν να το παίξουν άγιες, ήδη έχουμε δοκιμές με F-16 που πετάνε αυτόνομα με τεχνητή νοημοσύνη και όλο και περισσότερες χώρες ερευνούν την χρήση της τεχνητής νοημοσύνης στον στρατό.